¿Y si tu móvil pudiera contarte lo que está viendo? No solo capturarlo, sino entenderlo. Desde identificar una flor hasta traducir un cartel en otro idioma o decirte qué restaurante tienes delante. Con la llegada de iOS 18.4, Apple ha empezado a convertir esa visión en realidad para más usuarios de iPhone.

La función Visual Intelligence, hasta ahora reservada a los modelos más nuevos, se extiende por fin a otros dispositivos. Pero, ¿qué es exactamente esta tecnología? ¿Y por qué Apple cree que será central en el futuro de sus productos, desde los iPhone hasta los AirPods?

Qué es Visual Intelligence y cómo convierte la cámara en un sensor inteligente

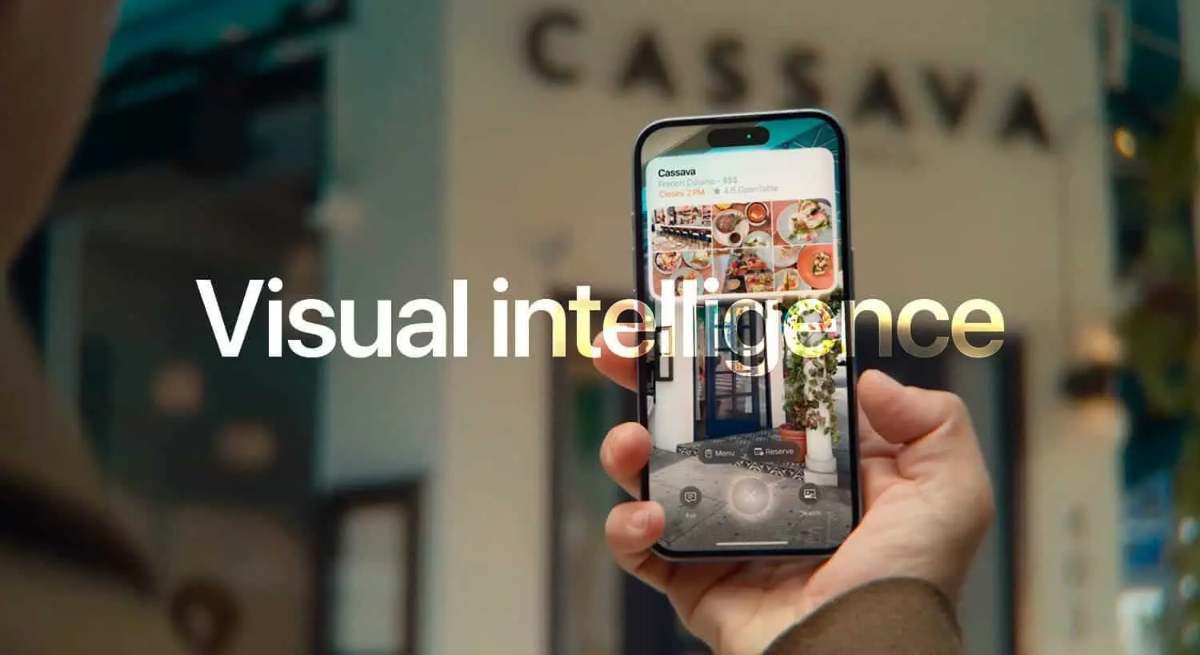

No se trata de una simple mejora fotográfica. Visual Intelligence es una herramienta de inteligencia artificial que usa la cámara del iPhone como un ojo analítico. Gracias a esta función, el dispositivo puede:

- Identificar objetos, plantas y animales

- Traducir textos en tiempo real

- Resumir documentos visuales

- Leer en voz alta lo que capta la cámara

- Reconocer lugares, negocios y monumentos

En lugar de abrir varias apps para estas tareas, basta con apuntar la cámara. La información aparece contextualizada al instante, gracias a una combinación de reconocimiento visual, geolocalización e IA generativa.

Apple describe esta función como una forma de "aprender más sobre el mundo a tu alrededor", y ese es precisamente su núcleo: transformar la cámara de los iPhone en una herramienta de comprensión del entorno.

Los nuevos iPhone compatibles con Visual Intelligence tras iOS 18.4

Cuando se lanzó por primera vez en iOS 18.2, Visual Intelligence estaba limitada a los iPhone 16 Pro y 16 Pro Max, los únicos modelos con el nuevo botón de Control de Cámara. Pero iOS 18.4 ha cambiado el juego.

Ahora, también pueden activar Visual Intelligence los siguientes dispositivos:

- iPhone 15 Pro

- iPhone 15 Pro Max

- iPhone 16e

Estos modelos pueden acceder a la función añadiéndola al botón de acción, al Centro de Control o incluso a la pantalla de bloqueo. Así, Apple democratiza poco a poco una tecnología que antes parecía reservada a unos pocos.

No solo se trata de ampliar el acceso: también se están añadiendo funciones con cada versión. Ya en iOS 18.3, Visual Intelligence incorporó nuevas capacidades, y todo apunta a que esto continuará en las siguientes actualizaciones del sistema.

El plan a largo plazo de Apple: que todos los dispositivos vean, comprendan y respondan

Apple no se detiene en el iPhone. Según fuentes como Mark Gurman, el objetivo de la compañía es llevar Visual Intelligence a más productos del ecosistema. ¿Cómo? Integrando cámaras en lugares donde antes no las había, como:

- AirPods con cámara, capaces de entender gestos o detectar objetos

- Nuevas versiones del Apple Watch con lente integrada, pensadas para interactuar con el mundo visual sin necesidad de un móvil

Esta expansión responde a una estrategia clara: que todos los dispositivos Apple puedan ver y procesar el mundo físico a través de sus propias lentes y sin depender de tecnologías externas. Apple quiere que Visual Intelligence funcione con sus propios modelos de IA, en lugar de los desarrollados por OpenAI o Google.

Hacia una cámara que piensa, en lugar de solo ver

Cada actualización es un ladrillo en un edificio más grande. Visual Intelligence no es solo una novedad útil, es una pieza clave en el rediseño de cómo usamos nuestros dispositivos. Hoy puedes apuntar la cámara para traducir o identificar algo. Mañana, puede que el dispositivo te lo diga antes de que lo preguntes.

Apple, como ya hizo con el Face ID o el chip Neural Engine, está trazando una hoja de ruta donde la inteligencia artificial se vuelve invisible, integrada y ubicua. Lo interesante es que empieza por algo tan cotidiano como la cámara.