Desde hace varios años ya, los teléfonos móviles se han pasado ha llamar smartphones (teléfonos inteligentes) debido a todas las capacidades y funciones que ofrecen. No obstante, estos dispositivos han funcionado siempre bajo los comandos y movimientos que las personas les ordenan.

Pero gracias a la llegada de la Inteligencia Artificial, la tecnología que vuelve hábiles a las máquinas, el concepto de dispositivo inteligente va a cambiar, y el Proyecto Astra de Google es de los primeros ejemplos que lo demuestran.

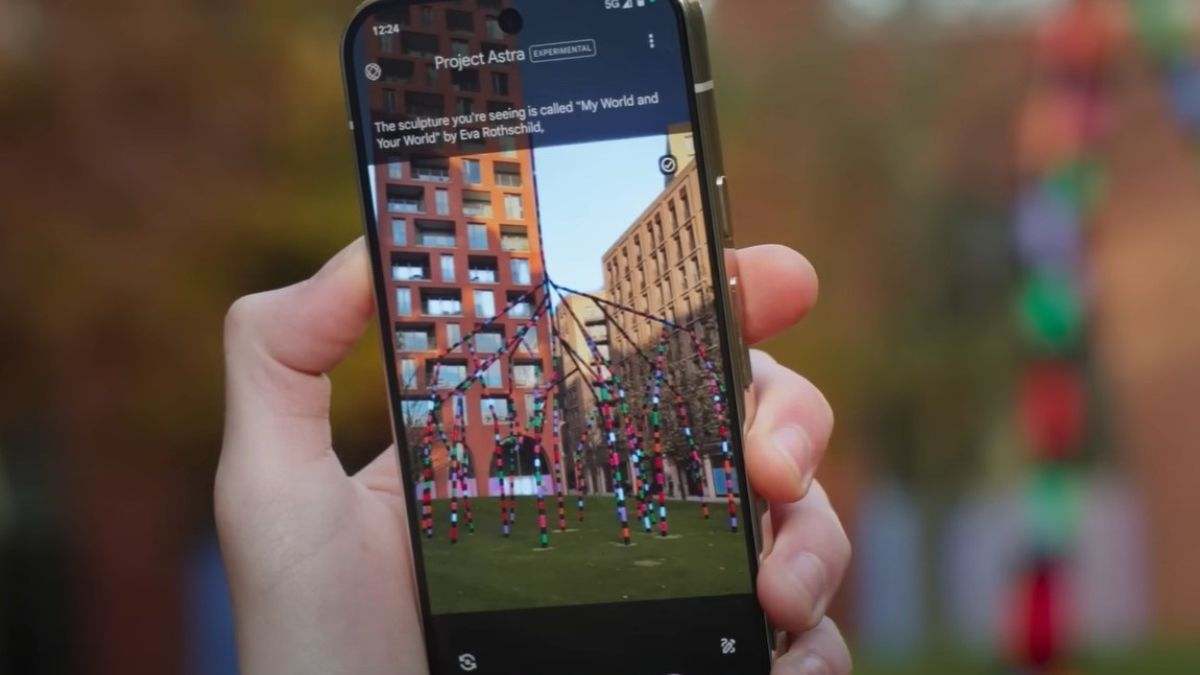

La compañía ha mostrado algunas de las capacidades que ofrecerá su prototipo de asistente universal de IA, ya sea integrado en un 'smartphone' o en unas gafas inteligentes, que podrá responder cualquier pregunta de los usuarios teniendo en cuenta el entorno que les rodea y sus acciones en tiempo real.

En el caso de Proyecto Astra en un 'smartphone' Pixel, el usuario interactúa con el asistente mediante comandos de voz y la cámara, con lo que es capaz de comprender tanto las imágenes del entorno en tiempo real, como los comentarios y solicitudes que los el usuario realiza en voz alta.

Para ello, basta con que el usuario enfoque la cámara sobre lo que quiera obtener información, por ejemplo, un monumento en la calle, un plato de comida o un electrodoméstico, y pregunte al mismo tiempo cuestiones relacionadas. Así, el asistente podría ofrecer ayuda con datos relevantes sobre el monumento, detallar los ingredientes con los que se ha preparado el plato de comida o explicar qué programa es más idóneo para lavar una determinada prenda en la lavadora.

Las respuestas del asistente se muestran tanto escritas en la pantalla del 'smartphone' como mediante respuesta de voz, para una conversación fluida con el usuario.

Asimismo, el asistente también puede realizar búsquedas o recomendaciones relacionadas con, por ejemplo, una lista de restaurantes anotados en una hoja, simplemente con enfocar dicha lista, así como recordar información para ofrecérsela al usuario de forma rápida y sencilla posteriormente.