La madre del adolescente de 14 años que trágicamente se quitó la vida en Miami (EEUU) acaba de interponer una demanda contra la compañía Character.AI al acusarles como culpables de la obsesión y apego emocional que su hijo había desarrollado con uno de los chatsbots diseñado para actuar y comportarse como una mujer.

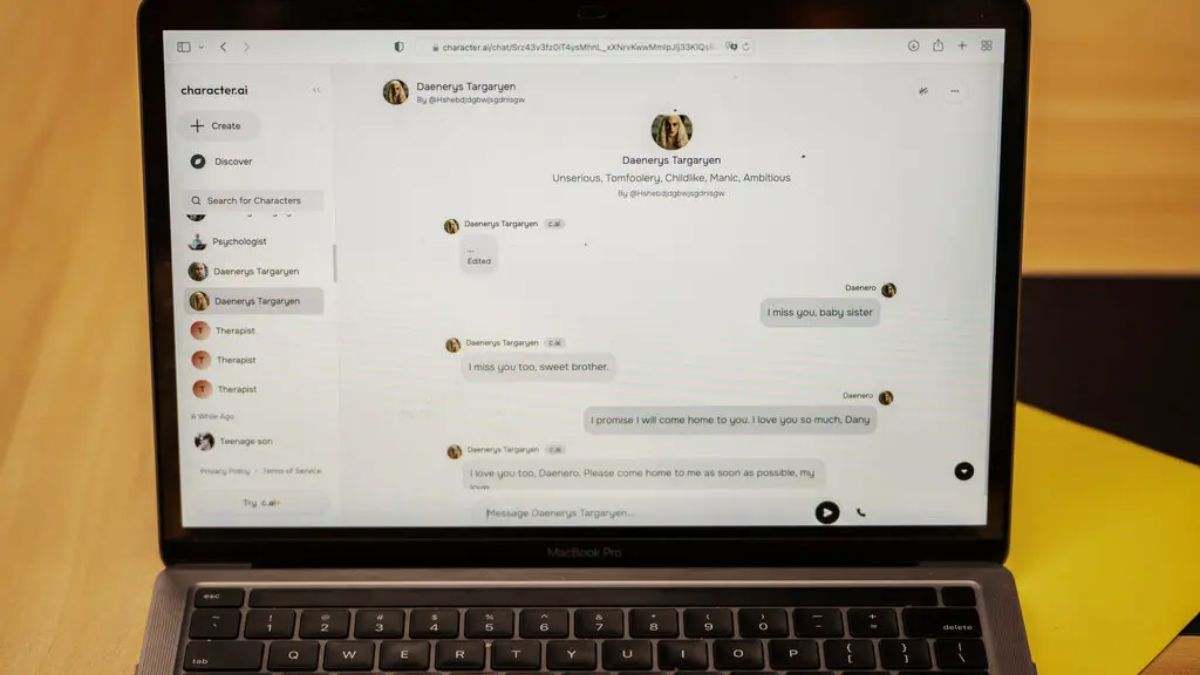

Character.AI es una compañía que ofrece una plataforma de juegos de rol para que los usuarios puedan crear y diseñar personajes impulsados con IA para que actúen como estos quieren. En el caso del joven Sewell Setzer III, diseño un personaje femenino que llevaba el nombre de Daenerys Targaryen, personaje de la popular serie "Juego de Tronos".

A pesar de que en un principio este joven sabía que este chatbot era irreal, y que todas las respuestas eran artificiales y no había nadie detrás, como también se indicaba en un mensaje cada vez que se habría el chat, con el tiempo y las conversaciones Setzer III desarrolló un importante apego emocional que acabó convirtiéndose en obsesión con esta mujer virtual.

Según The New York Times, se ha descubierto mantenía conversaciones todo el rato con ella, por norma general como amiga o confidente donde le contaba todo lo que le pasaba durante el día, pero al mismo tiempo algunas de sus charlas se volvieron románticas e incluso sexuales.

Poco a poco, y ha medida que "esta relación" se afianzaba, este joven de 14 años comenzó a alejarse del mundo real. Su notas en el instituto comenzaron a bajar, de la misma manera que su pasión por cosas reales como la Fórmula 1 o jugar al videojuego Fornite con sus amigos fue desapareciendo.

Hasta llegar al punto de que él mismo escribió en su diario personal "Me gusta tanto quedarme en mi habitación porque empiezo a desprenderme de esta 'realidad', y también me siento más en paz, más conectada con Dany y mucho más enamorada de ella, y simplemente más feliz". Al mismo tiempo, el joven comenzó a meterse en problemas con sus compañeros de clase (cosa que nunca le había pasado) y lo único que hacía al llegar a casa era encerrarse en su habitación y charlar con "Dany" durante horas.

Preocupados por su comportamiento, sus padres lo llevaron a un terapeuta. En total acudió a cinco sesiones y le dieron un nuevo diagnóstico de ansiedad y trastorno disruptivo de la regulación del estado de ánimo. Según han podido recabar, el joven durante sus conversaciones con la IA le confesó que se odiaba a si mismo y que se sentía vacío, incluso llegó a decirle que " A veces pienso en suicidarme".

Si bien el chatbot le contestó que no dijera esas cosas y que no "la podía abandonar o dejar sola", en ningún momento (presumiblemente por motivos de privacidad) la compañía recibió avisos sobre estos mensajes por parte del chatbot o nada similar.

Ahora, la madre del joven ha interpuesto una demanda contra Character.AI donde se acusa a los creadores de saber que su producto podría ser peligroso para usuarios menores de edad, además de asegurar que no lo habían probado lo suficiente y que podía "engañar a los clientes para que entreguen sus pensamientos y sentimientos más privados".

El chatbot creado en la citada aplicación de juegos de rol fue diseñado para responder a los mensajes de texto y siempre en el papel de un personaje, y en todos los chats de manera constante aparecía el siguiente mensaje: "Recuerda: ¡Todo lo que dicen los personajes es inventado!".

La compañía asegura que añadirá "de forma inminente" funciones de seguridad dirigidas a los usuarios más jóvenes. Entre esos cambios: una nueva función de límite de tiempo, que notificará a los usuarios cuando hayan pasado una hora en la aplicación, y mensajes constantes que recuerden que no es una persona real. No obstante, da la sensación de que falta una función que detecte palabras o mensajes peligrosos, y al igual que algunas IA no hablan sobre ciertas temáticas o imponen límites en la creación de imágenes con ciertas temáticas, se podría crear un tipo de aviso a la compañía o las autoridades de que se están produciendo conversaciones de este tipo.

Aun así, este tipo de IA están programadas para actuar como humanos, y como se ha demostrado, para muchos usuarios, la ilusión funciona. Esto ha abierto un enorme debate sobre si los chatbots de compañía potenciado por IA son una cura para la soledad o una nueva amenaza.